¿Por qué vivimos en sociedades? (2): La teoría de juegos (por Jan Doxrud)

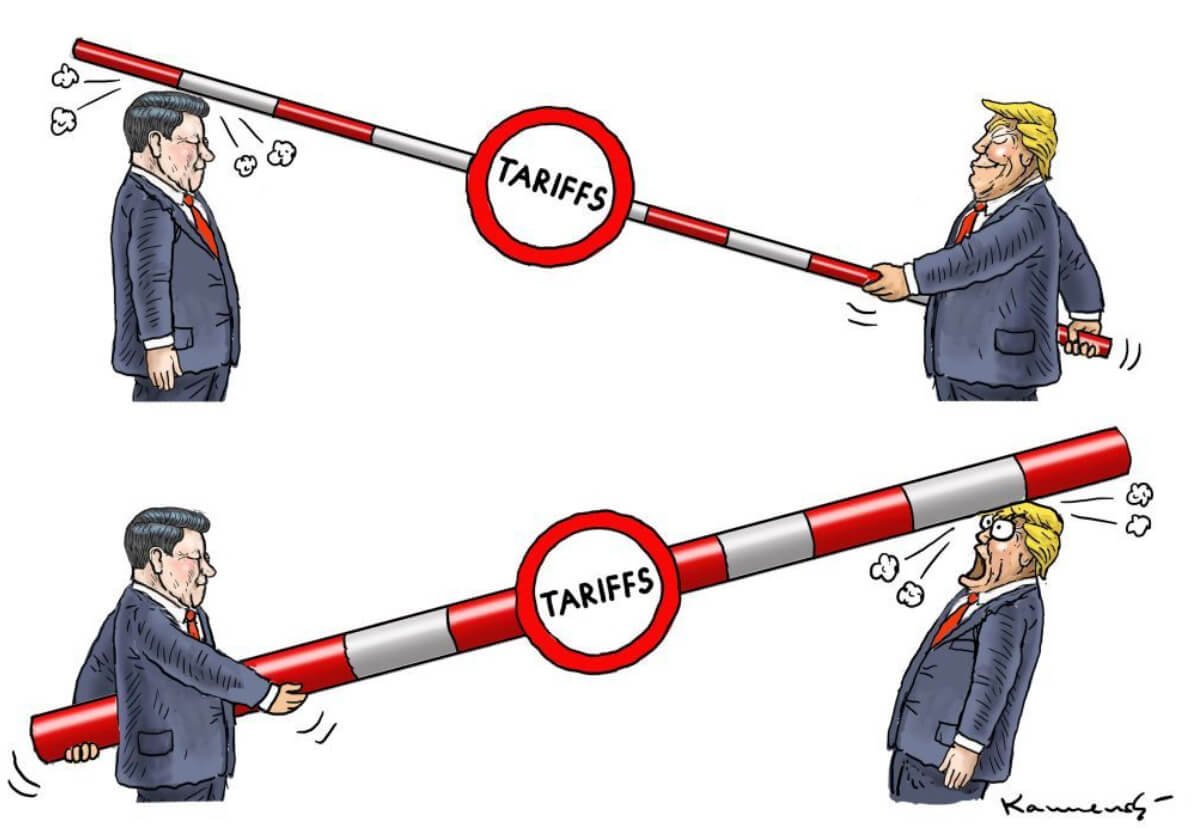

Me detendré un momento en el tema de la elección racional y la teoría de juegos mencionado en el artículo anterior, puesto que arroja luces en torno al problema acerca de cómo puede surgir la cooperación a partir de un mundo competitivo. La teoría de juegos fue desarrollado en la década de 1940 por el matemático John von Neumann (1903-1957) y el economista Oskar Morgenstern (1902-1977). Desde el ámbito de las matemáticas y la economía, esta teoría fue aplicada también a otras disciplinas como la biología evolutiva. La teoría de juegos, básicamente, plantea un conflicto e interacción entre dos o más personas. Los elementos del juego incluye: jugadores, acciones, estrategias, información, pagos y equilibrio. Los participantes son personas racionales, es decir, buscan maximizar su beneficio, intentan sacar la máxima ventaja en una situación dada, de manera que intentará buscar la estrategia que más le beneficie. Dentro de la teoría de juegos están aquellos de suma cero, es decir, donde uno gana y otro pierde, y los de suma no cero, vale decir, donde ambas partes pueden ganar e incluso perder.

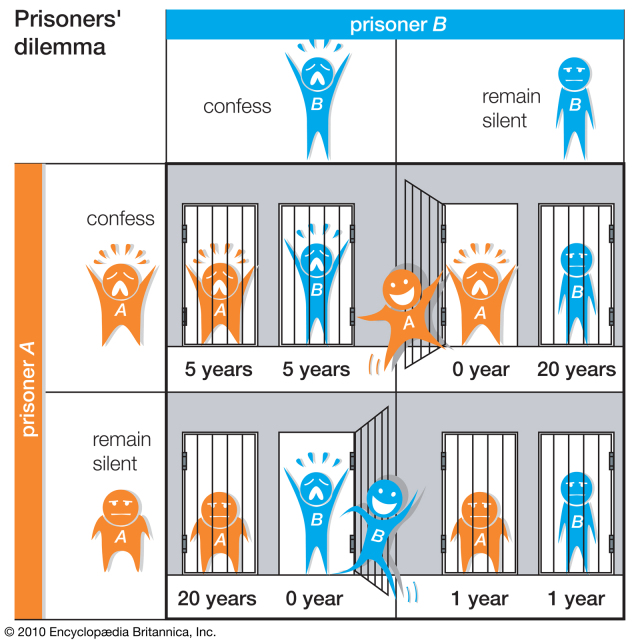

En el caso del dilema del prisionero tenemos a dos sujetos X e Y que son tomados prisioneros de manera arbitraria. Ambos están incomunicados y están obligados a confesar por algo que no hicieron y se les da a cada uno las siguientes opciones:

1-Si X no confiesa y tú si lo haces, es decir, declaras contra X, sales libre y X es condenado a 10 años de cárcel.

2-Si X confiesa y tú no confiesas, la situación es la inversa, es decir, X sale en libertad y mientras que tú eres condenado a 10 años de cárcel.

3-Si X e Y confiesan, cada uno recibirá una sentencia de 5 años.

3-Si X e Y no confiesan, cada uno recibirá una condena de 1 año.

Fuente BBC

Uno podría responder de inmediato que, pase lo que pase, la única opción es siempre confesar, es decir, declara contra la otra parte. Si tú confiesas y resulta que X no, entonces sales libres. Si confiesas y X también lo hace entonces recibirás 5 años. La persona arriesga más si opta por no confesar. Ahora bien, debemos tener en consideración que ambos reciben la misma información y se les ofrece las mismas opciones, por lo que X razonará de la misma forma, de manera que el resultado esperado será que ambos confiesen y que cada uno recibirá una condena de 5 años. Si ambos prisioneros tuvieran oportunidad de comunicarse y fueran expuesto a este juego de manera repetida, entonces llegarían a una solución mutuamente beneficiosa que sería la de no confesar para que así ambos reciban sólo 1 año. El único problema es si, a la hora de volver a las celdas, una de las partes se fiará de que su compañero cumpla su palabra ya que, si uno la cumple y el otro confiesa, entonces el sale libre y tu recibirás 10 años.

Como explica el científico e investigador del Chandra X-ray Science Center del MIT, Michael A. Nowak, en la vida cotidiana todos nos enfrentamos a este dilema de una u otra manera. Por ejemplo, cuando tengo que decidir si ofrecerme o no a ayudar a mi compañero de trabajo a realizar su trabajo durante las vacaciones, aún sabiendo que éste compite por el mismo puesto que yo quiero. También esta el caso de la carrera armamentista entre países, tal como sucedió durante la Guerra Fría. Sabemos que en este último caso los países, en lugar de tomar la decisión correcta, esto es, cooperar, prefirieron continuar armándose sin cesar, destinando una gran cantidad de recursos en armas nucleares.

Morgenstern y von Neumann (https://www.privatdozent.co/p/oskar-morgensterns-transformation)

Otro tipo de juego es el dilema del prisionero iterado. Fue el biólogo Robert Trivers quien introdujo el juego repetido en un análisis del comportamiento animal, lo que se denomina el “dilema del prisionero iterado” (repetido). Un autor que realizó aportes en este campo fue el matemático israelí Robert J. Aumann. Como explica Nowak:

“...Aumann mostró que con las repeticiones del juego puede surgir la cooperación pacífica, incluso cuando los jugadores tienen fuertes y encontrados interés a corto plazo. Un jugador colaborará con otro porque sabe que si hoy se le hace trampa, mañana podrá vengarse del tramposo. Parecía que la perspectiva de una represaliavengativa facilitaba el camino para una cooperación amigable. Según esta visión, es más posible que la cooperación emerja de la nada que del cálculo racional del interés propio”[1].

Continúa explicando Nowak que hasta ese momento no se sabía cómo jugar el juego cuando este podía repetirse. De acuerdo a los trabajos de Aumann existía una estrategia que podía inducir a un contrincante a cooperar, pero no se sabía cuál era la buena y la mala estrategia. Para saber jugar el juego había que esperar el trabajo del matemático y cientista político Robert Axelrod. Axelrod, tal como procedió Trivers, extendió este escenario del dilema del prisionero e hizo también de este un “dilema del prisionero iterado”. Como lo resume el filósofo de la ciencia Chris Buskes, comenzó su investigación con las siguientes tres suposiciones:

1-“La cooperación puede surgir en un mundo de puros tramposos. La cooperación surge poco a poco sobre la base de la reciprocidad. La cooperación da mejores resultados que el egoísmo.

2-Una estrategia de cooperación puede florecer en un mundo donde se ponen a prueba muchas estrategias diferentes. La cooperación puede ser la mejor estrategia.

3-Si la cooperación sobre la base de la reciprocidad es ampliamente aceptada, puede protegerse contra una invasión de estrategias menos cooperativas. En tal caso, los tramposos no tendrán la posibilidad de reconquistar la sociedad”[2].

Axelrod logró corroborar las primeras dos suposiciones. Esto lo hizo por medio de un torneo informático que organizó en 1979. En ese año, distintos expertos enviaron sus programas informáticos para jugar en el torneo del prisionero iterado. A los participantes se les asignaban puntos, por ejemplo, si ambos colaboraban recibirían 3 puntos, si ambos traicionaban recibían 1 punto, si uno traicionaba al otro recibía 5 puntos. Los distintos programas competían tanto entre sí como contra sí mismos. Axelrod por su parte también tenía su propio programa llamado “Random” que jugaba de forma aleatoria a cooperar o traicionar. El resultado de esto fue que aquellos programas que intentaban engañar a sus contrincantes ganaron menos puntos, ya que el contrincante castigaba esta conducta con una traición para así evitar ser explotado y engañado en la próxima interacción.

El programa ganador fue el “Tit-for-Tat” del matemático ruso Anatol Rapoport (1911-2007). Este resultó ser el programa más simple y operaba de la siguiente manera: comenzar cooperando para luego realizar lo mismo que el otro había hecho en la última jugada. Como explica Buskes, este programa no tenía posibilidad de ganar en una confrontación individual, ya que si el primero lo engañaba una vez, ganando de esa manera 5 puntos, luego “Tit-for-Tat” comenzaría a copiar esa acción, aunque nunca lograría recuperar esos 5 puntos. Pero lo importante era la puntuación total, y sucedió que este programa conseguía muchos puntos cuando jugaba contra sí mismo obteniendo de esa manera los tres puntos. Ahora bien, cabe aclarar que este se trató de un dilema del prisionero iterado infinito, es decir, los jugadores no sabían cuantas rondas se jugarían.

https://leverageedu.com/explore/learn-english/tit-for-tat-idiom-meaning-with-example/

https://nepalitimes.com/opinion/comment/trade-tit-for-tat

La sorpresa es que “Tit-for-Tat” logró ganar un segundo torneo donde participaron 63 programas. Tenemos entonces que Axelrod confirma las dos primeras suposiciones mencionadas. En resumen tenemos lo siguiente:

a) Es posible que la cooperación pueda surgir sobre de un mundo donde predomina el egoísmo y la potencial traición. La cooperación surge sobre la base de la reciprocidad.

b) Al momento de poner a prueba distintas estrategias sucede que la más beneficiosa es la estrategia de cooperación.

Faltaba corroborar la tercera suposición: “Si la cooperación sobre la base de la reciprocidad es ampliamente aceptada, puede protegerse contra una invasión de estrategias menos cooperativas”. Para esto, Axelrod realizó un torneo ecológico en donde los programas de los torneos anteriores podrían reproducirse de generación en generación – de ronda en ronda – de manera que si el programa X conseguía dos veces más puntos, entonces aparecería el doble de veces en la próxima generación. Como explica Buskes, este era un torneo ecológico y no evolutivo, ya que en el último caso los programas debían sufrir pequeños cambios o mutaciones casuales, mientras que en una simulación ecológica lo que cambiaba era la distribución de los programas. Vayamos a los resultados de este experimento. Resultó que los programas que en torneos anteriores habían salido en último lugar, desaparecieron en la quincuagésima generación o ronda. En cambio, aquellos programas que habían estado en los primeros lugares se multiplicaron y, claro está, “Tit-for-Tat” fue el gran ganador. Chris Buskes resume los cuatro consejos de Axelrod a los líderes mundiales, consejos que se basan en los cuatro requisitos que “Tit-for-Tat” cumplía :

1-Evitar los conflictos innecesarios cooperando mientras el otro también lo haga.

2-Demostrar que se siente provocado si el otro le engaña sin motivo.

3-Ser clemente en cuanto al otro reaccione al observar su rechazo y corrija su conducta.

4-Mantener una conducta transparente y previsible para que el otro pueda adaptarse a su pauta de conducta.

Buskes explica que “Tit-for-Tat” no es infalible, ya que tendría problemas en un torneo en que no pudiese jugar con otros “Tit-for-Tat”, y en un entorno plagado de tramposos y un único “Tit-for-Tat”, este útlimo no podría propagarse. Posterior a esto, el académico de biologíaa y matemáticas, Martin Nowak, y el matemático Karl Sigmund, elaboraron un programa denominad “Pavlov” que operaba de manera similar a “Tit-for-Tat”, es decir, seguía la misma estrategia que en la jugada anterior siempre y cuando ésta haya dado un resultado favorable, en caso contrario la estrategia debe cambiar. Nowak narra sobre la racha perdedora de su programa en las simulaciones y se percató de que había una nueva estrategia que había ganado y consistía en las siguientes instrucciones

1-Si ambos hemos cooperado en la última jugada, entonces yo cooperaré una vez más.

2-Si ambos hemos desertado, entonces cooperaré (con cierta probabilidad).

3-Si tu has cooperado y yo he desertado, entonces volveré a desertar.

4-Si tú has desertado y yo he cooperado, entonces yo desertaré.

Al respecto escribe Nowak: “En suma, esto significa que siempre que hayamos hecho lo mismo, yo cooperaré, mientras que si hemos hecho algo diferente, entonces desertaré. En otras palabras, esta estrategia ganadora hace lo siguiente: si lo estoy haciendo bien, repetiré mi movimiento. Si lo hago mal cambiaré lo que estoy haciendo”[3].

De acuerdo a Buskes, y siguiendo al zoólogo y divulgador científico Matt Ridley, el quid de este juego del prisionero iterado es si se puede o no confiar en el otro, y en esto resulta crucial el papel de las emociones e instintos sociales como reguladores en los numerosos análisis de costos y beneficios.

Por ejemplo, tenemos lo que el primatólogo Frans de Waal denomina “reciprocidad simétrica” y la “reciprocidad calculadora”, cuando estamos en presencia de extraños o de quienes no nos fiamos por completo. Martin A. Nowak, quien es director del Programa para Dinámicas Evolutivas de la Universidad de Harvard, también se ha preocupado de abordar la pregunta sobre cómo puede surgir la cooperación, el altruismo y la abnegación en un mundo competitivo.

De acuerdo con Nowak la capacidad de cooperar va de la mano con el triunfo de la lucha por la supervivencia. Añade el autor: “Mis estudios demuestran que la cooperación es enteramente compatible con la aritmética dura de la supervivencia en un entorno inexorablemente cruel y competitivo”[4]. Más adelante concluye el mismo autor:

“La cooperación – que no la competición – es lo que alimenta la innovación. Para fomentar la creatividad, y para estimular a la gente a que encuentre ideas originales, hay que usar el deseo de la zanahoria, no el miedo del palo. La cooperación es la arquitectura de la creatividad a través de la evolución, desde las células hasta los seres multicelulares, los hormigueros, los pueblos y las ciudades. Sin cooperación no puede haber ni construcción ni complejidad en la evolución”[5].

Por cooperación, Nowak entiende algo más que el trabajo para alcanzar un objetivo común. Para el biólogo, la cooperación significa que competidores en potencia deciden ayudarse unos a otros, algo que carece de sentido desde el punto de vista del darwinismo tradicional, ya que la cooperación significa, para el competidor, dañar su propio bienestar. Nowak explica que, por medio de cinco mecanismo, la selección natural se ha asegurado de que seamos capaces de obtener más de la vida social que del empeño de una vida solitaria y egocéntrica, similar al estado de naturaleza de Thomas Hobbes. Estos cinco mecanismos pueden trabajar de manera separada o en conjunto.

Martin Nowak (http://www.martinnowak.com)

El primer mecanismo es la repetición o reciprocidad directa, esto es, el famoso “te rasco la espalda si tú rascas la mía”. Nowak recuerda las siguientes palabras de David Hume en su “Tratado de la naturaleza humana” que reflejan este primer mecanismo: “Aprendo a servir a otro, sin albergar ninguna simpatía real por él: porque preveo que él podrá devolverme el servicio en cuanto se dé tal ocasión”[6]. El segundo mecanismo es la reputación o reciprocidad indirecta, en virtud de la cual mi comportamiento hacia X dependerá de lo que X haya hecho a los demás. El autor explica que, mientras la reciprocidad directa guarda relación con la experiencia que uno tiene de otra persona, la reciprocidad indirecta toma en cuenta también la experiencia de otras personas. El tercer mecanismo es la selección espacial, proceso presente en las múltiples redes sociales en donde los cooperadores pueden prevalecer construyendo redes y agrupamientos en los que se ayudan entre ellos.

El cuarto mecanismo es la selección multinivel, esto es la selección natural a nivel de grupos. Nowak lo resume con las siguientes palabras de Charles Darwin: “No puede haber ninguna duda de que en una tribu que incluye muchos miembros […] siempre dispuestos a ayudarse mutuamente y a sacrificarse por el bien común saldrá victoriosa por encima de otras tribus; y esto sería selección natural”[7]. Ahora bien, Nowak hace una precisión y es que este mecanismo cooperativo funciona de manera óptima si existen muchos grupos pequeños y de manera menos óptima si existen pocos grupos grandes. El quinto mecanismo es la selección por parentesco, donde los vínculos familiares y el compartir antepasados en común juegan un rol fundamental

Fin parte 2

[1] Martin A. Nowak y Roger Highfield, Supercooperadores. Las matemáticas de la evolución, el altruismo y el comportamiento humano (o por qué nos necesitamos los unos a los otros para triunfar) (España: Ediciones B, 2012), 54.

[2] Chris Buskes, La herencia de Darwin. La evolución en nuestra visión del mundo (España: Herder Editorial, 2009), 347.

[3] Michael A. Nowak y Roger Highfield, op. cit., 71.

[4] Ibid., 19.

[5] Ibid., 20.

[6] Ibid., 343.

[7] Ibid., 344.